Kate Crawford : « l’IA est une nouvelle ingénierie du pouvoir »

« « Nous sommes confrontés à des systèmes techniques d’une puissance sans précédent, qui impactent très rapidement tous les secteurs, de l’éducation à la santé, de l’économie à la justice … Et la transformation en cours est concomitante à la montée de l’autoritarisme et du populisme ». Cette évolution n’est pas une coïncidence, avance la chercheuse : l’un et l’autre interrogent la centralisation du pouvoir et nécessitent d’améliorer notre compréhension critique des formes de pouvoir. Cette combinaison renforce les difficultés pour maîtriser ces outils et les rendre responsables et nécessite de comprendre en profondeur les relations entre politique, pouvoir et IA. »

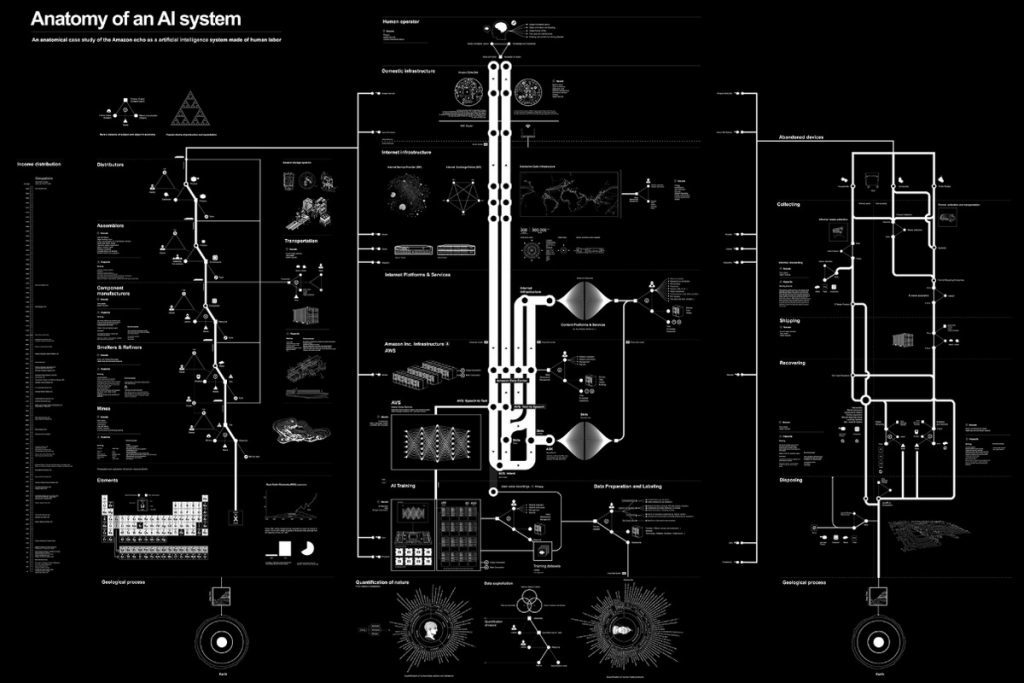

« Je ne suis qu’un ingénieur » avait répondu l’un des coauteurs d’un projet de recherche de police prédictive dont les résultats s’étaient révélés particulièrement biaisés. Le genre de réponse qui énerve particulièrement Kate Crawford (dont la conférence d’inauguration de la chaire IA et Justice à l’ENS est ici résumée par Hubert Guillaud), spécialiste américaine des « implications sociales des systèmes techniques » comme le Big Data, les algorithmes et l’intelligence artificielle dont tout le travail consiste à faire comprendre aux concepteurs de nouveaux outils techniques qu’ils ont une responsabilité (alors que « cette façon de ne pas reconnaître sa responsabilité est en passe de devenir une norme »). Pour elle, « Nous entrons dans une époque où des procédés techniques sont transformés très rapidement en systèmes. Ce faisant, ils renforcent des biais culturels et les automatisent, en les rendant à la fois invisibles et incontournables ». Or l’intelligence artificielle n’est pas qu’une technique ou une technologie mais aussi une « pratique sociale qui nécessite de comprendre qui travaille sur ces systèmes, quelles données sont utilisées, comment sont-elles classées ». Et surtout une « infrastructure industrielle particulièrement concentrée » qui en fait « une nouvelle ingénierie du pouvoir ». Loin des rêves de neutralité objective, la démultiplication des données a démultiplié les discriminations puisque « les jeux de données reflètent les hiérarchies sociales et les structures de pouvoir existantes » et que « les biais sont devenus le matériel brut de l’IA ». Pour Crawford, « nous n’avons pas de procédures fiables pour améliorer ces systèmes décisionnels correctement … La correction « technique » de ces systèmes – présentée comme neutre et objective – risque surtout de refermer les débats et l’intérêt actuel à regarder concrètement comment ils fonctionnent et les problèmes qu’ils posent ». Au fond, ces systèmes sont « dangereux quand ils échouent, nocifs quand ils fonctionnent » et « améliorer un système injuste ne peut que créer un plus grand préjudice ». La vraie question que devraient ainsi se poser les concepteurs de systèmes serait alors : « Votre outil donne-t-il plus de pouvoir aux plus puissants ? »

(30 septembre 2019)